32. Travaux pratiques : configuration d’un système de messagerie

32.1. Installation de postfix

32.2. DNS – préparation préalable

32.3. Configuration du serveur postifx.

32.3.1. Installation du serveur SMTP

32.3.2. Test de la configuration du serveur SMTP

32.3.3. Installation du serveur PostOFFICE Pop3

32.3.4. Test du serveur Pop3

32.3.5. Utilisation des alias

32.3.6. Utilisation des listes

32.3.7. La gestion des erreurs

32.3.8. Mise en place du service IMAP sur le serveur

32.3.9. Plus loin dans le décryptage

32.3.10. Mise en place du client IMAP

32.3.11. Le relayage

32.3.12. Autres techniques de filtrage et autres services de postfix

33. Installation d’un serveur DDNS avec bind et DHCP

33.1. Résumé

33.2. Éléments sur le service DDNS

33.3. Les aspects sur la sécurité

34. Travaux pratiques : DDNS

34.1. Réalisation

34.2. Les fichiers de configuration

34.2.1. Le fichier named.conf

34.2.2. Le fichier de zone directe

34.2.3. Le fichier de zone in-addr.arpa

34.2.4. Le fichier rndc.conf

34.2.5. Le fichier de clé partagée

34.2.6. Le fichier dhcpd.conf

34.3. Procédure de tests des services

34.4. Intégration des services

34.5. Générer un nom dynamiquement pour les clients DHCP

35. Installation d’un service Web-mail

35.1. Présentation

35.2. Architecture générale du service

35.3. Installation et configuration OpenWebmail

35.3.1. Préparation de la machine

35.3.2. Installation d’OpenWebmail

35.3.3. Configuration de l’application OpenWebmail

35.3.4. Test de l’environnement

35.3.5. Configuration de l’environnement utilisateur

35.3.6. Test et environnement OpenWebmail

35.4. Application

36. Installation d’un service mandataire (Proxy SQUID)

36.1. Installer Squid

36.2. Configuration de squid

36.3. Initialisation de Squid

36.4. Les options de démarrage de Squid

36.5. Contrôler les accès

36.6. Contrôler les accès par authentification

36.7. Interface web de Squid et produits complémentaires

36.8. La journalisation

36.9. Configurer les clients

36.10. Forcer le passage par Squid (Proxy transparent)

36.11. Le redirecteur SquidGuard

36.12. Les applications non prises en charge par un service proxy

37. Travaux pratiques : installation de SQUID

37.1. Application

37.1.1. Préparation de la maquette

37.1.2. Installation et configuration du service proxy

37.1.3. Configuration du client

37.1.4. Mise en place d’une ACL simple

37.1.5. Utilisation de fichiers pour stocker les règles des ACL

37.1.6. Configuration des messages d’erreurs

37.1.7. Automatisation de la configuration des clients.

37.1.8. Installation et configuration du service proxy Squid transparent.

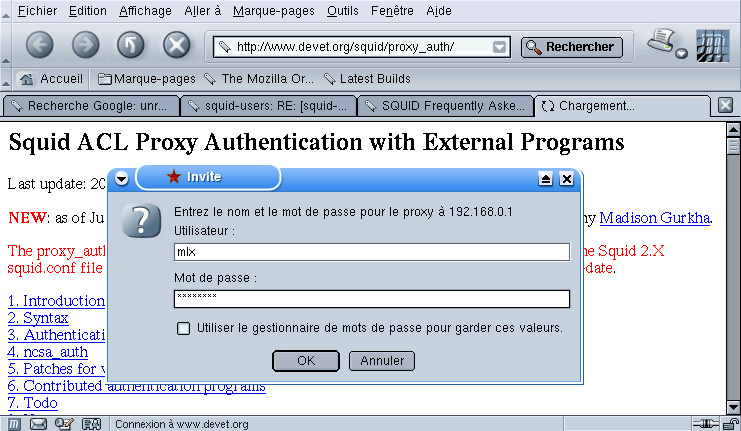

37.1.9. Mise en place de l’authentification

37.2. Liens

37.3. Annexes

37.3.1. Fichier squid.conf – testé avec Squid 2.5

37.3.2. Exemples d’ACLs Squid 2.2

37.3.3. ACL par authentification Squid 2.2

37.3.4. ACL sur des plages horaires Squid 2.2

38. Installation d’un serveur PostgreSQL avec Apache

38.1. Avant de démarrer

38.2. Les ressources sur PostgreSQL

38.3. Accès aux archives

38.4. Présentation

38.5. Présentation de PostgreSQL

38.5.1. Mode de fonctionnement de PostgreSQL

38.5.2. Langage de commande pour PostgreSQL

38.6. Présentation de PHP

38.6.1. Mode de fonctionnement de PHP

38.6.2. Le langage PHP

38.7. Dialogue client et serveurs PHP, Apache et PostgreSQL

38.8. Exemple de code

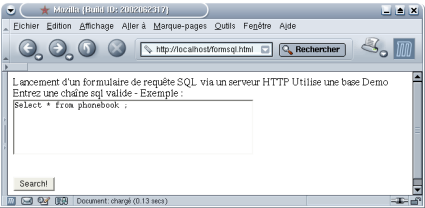

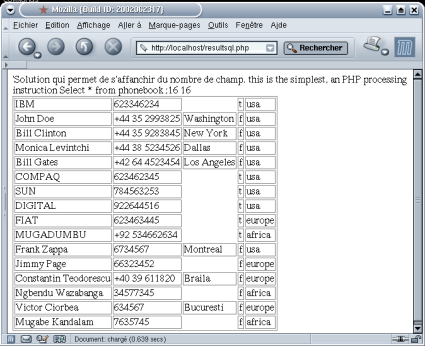

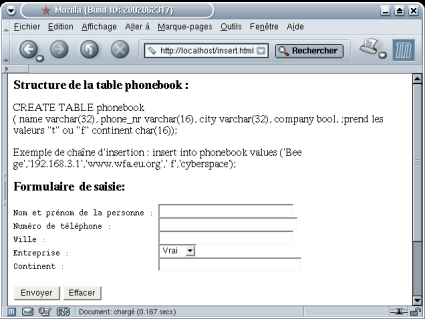

39. Travaux pratiques : PostgreSQL

39.1. Présentation

39.2. PostgreSQL

39.3. Test de la base

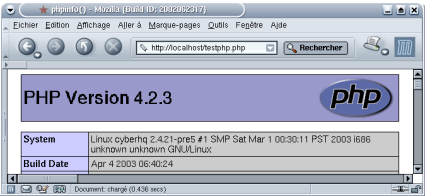

39.4. Serveur Apache et PHP

39.5. Serveur PostgreSQL/Apache et PHP

39.6. TP de synthèse

40. Surveillance, continuité de service

40.1. Principe de fonctionnement

40.2. Le matériel

40.2.1. Assurer la surveillance entre machines du cluster

40.3. Le logiciel

40.3.1. les pré-requis

40.3.2. L’installation

40.3.3. les fichiers de configuration

40.3.4. Mise en route

40.4. Exercices

41. Lilo : Linux Loader

41.1. Objectifs

41.2. Présentation de Lilo

41.2.1. Lilo

41.3. Documentation

41.4. Avant de commencer

41.4.1. Linux SGF

41.4.2. Les partitions

41.4.3. Disque IDE ou EIDE

41.4.4. Disques E(i)DE et CDROM

41.4.5. Disques E(i)DE et SCSI

41.4.6. Disques SCSI

41.4.7. Restriction du BIOS

41.5. Installation

41.5.1. MBR et PBR

41.5.2. Installer Lilo

41.5.3. Dos ou Windows 9.x

41.5.4. Windows NT

41.5.5. Exemple avec 3 systèmes

41.5.6. Avec d’autres systèmes

41.6. Lilo

41.6.1. Exécution de Lilo

41.6.2. Options de configuration

41.6.3. Outils de configuration

41.6.4. Exemple de fichier de configuration /etc/lilo.conf

41.6.5. Désinstaller Lilo

41.7. Choix du système

41.8. Autres solutions sans Lilo

41.8.1. Loadlin

41.9. rdev

41.10. initrd

41.10.1. Modules

41.10.2. initrd (suite)

41.11. Conclusion

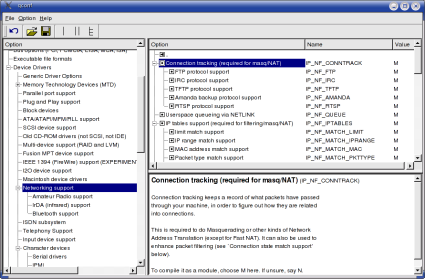

42. Travaux pratiques : Kernel et Noyau

42.1. Objectifs

42.2. Quelques remarques

42.3. Compilation

42.4. Installation et activation de module

42.4.1. make-kpkg pour les modules

42.5. Utilisation de Grub

42.6. Librairies

43. Init : Initialisation du système sous Linux

43.1. Documentation

43.2. 5 phases:

43.3. Premières explications:

43.4. Le processus de BOOT

43.5. Lilo

43.6. Init

43.6.1. Le répertoire /etc/rc.d

43.6.2. Séquences du programme init

43.6.3. Le niveaux d’exécution (runlevels)

43.6.4. Le niveau d’exécution par défaut

43.7. Le fichier /etc/inittab

43.8. Contenu d’un répertoire rcx.d

43.9. Comment choisir un mode d’exécution

43.10. Utilitaires de configuration

43.11. Arrêter ou démarrer un service

43.12. Ajout ou suppression d’un service

43.13. Placer une commande au démarrage du système

43.14. Arrêt du système

43.15. La commande shutdown

43.16. La disquette de BOOT

43.16.1. Création des disquettes

43.17. Dépannage

43.17.1. Mot de passe de root oublié

43.17.2. Démarrer en « single user »

43.18. Conclusion

44. TP : Sytème de gestion de fichiers

44.1. Swap

44.2. ext

44.3. loop

44.3.1. Alternative permettant de choisir le device loop

44.3.2. loop encrypté

44.3.3. loop iso9660

44.3.4. Fin du TP

45. CVS : Concurrent Version System

45.2. Horloge

45.3. Le dépôt (repository)

45.3.1. Initialisation du dépôt

45.3.2. Configuration

45.3.3. Accès au dépôt

45.3.4. Modules

45.4. Les commandes principales de CVS

46. Travaux pratiques : Concurrent Version System

46.1. Objectifs

46.2. Installer et configurer CVS

46.3. Gestion d’un projet en mode non connecté

46.4. Gestion d’un projet en mode connecté

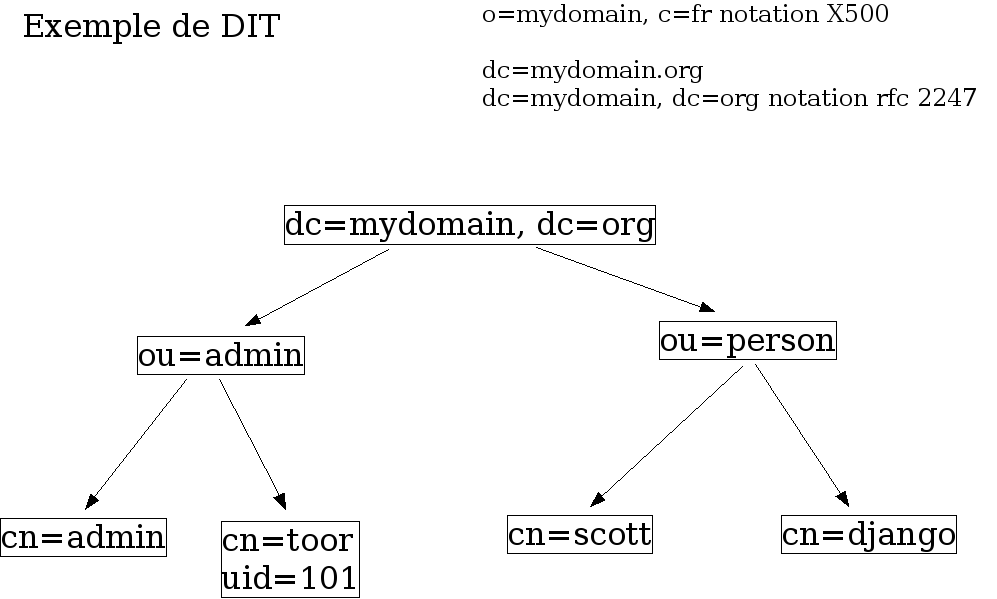

47. L’annuaire LDAP

47.1. Introduction

47.2. Présentation de LDAP

47.2.1. Le protocole

47.2.2. Le modèle de données

47.2.3. Les méthodes d’accès

47.2.4. Le langage de commande

47.3. Concevoir un annuaire

47.3.1. Déterminer les besoins, les données, le schéma

47.4. Créer une base de données

47.5. Installer, configurer et Administrer LDAP

47.5.1. Installer les packages sur le serveur

47.5.2. Les fichiers de configuration du serveur

47.6. Ressources

48. TP 1- Installer, configurer et Administrer LDAP

48.1. Installer les packages sur le serveur

48.2. Les fichiers de configuration du serveur

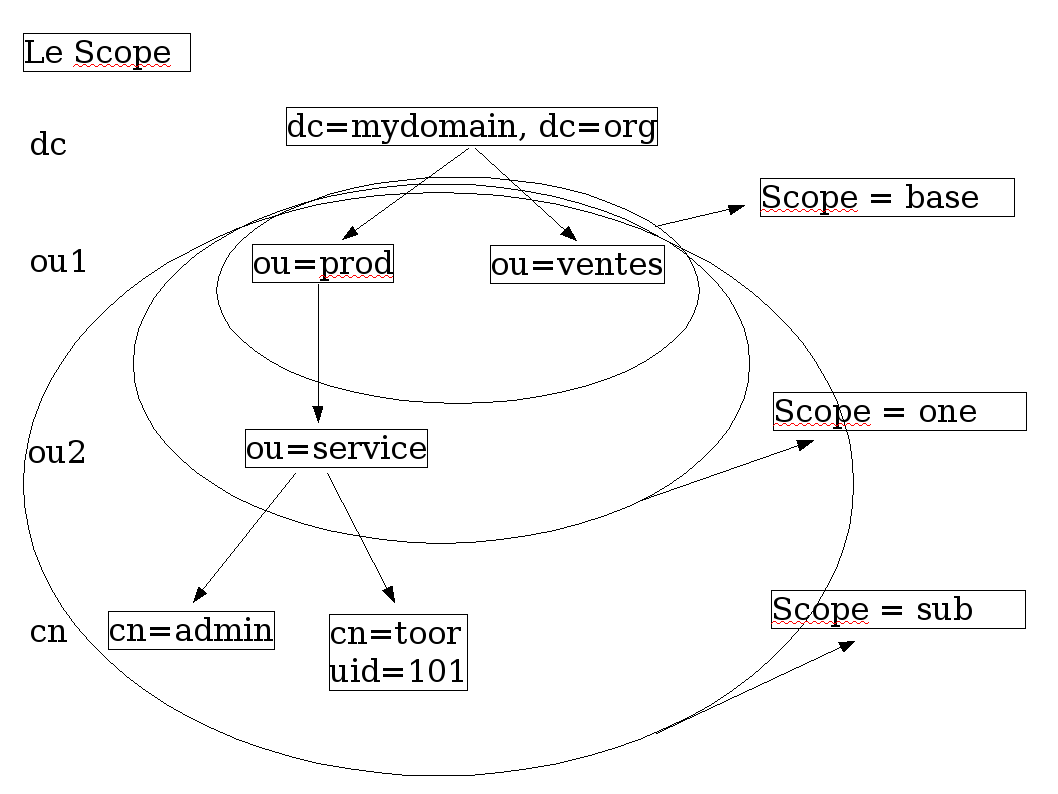

49. Installation d’un annuaire LDAP et utilisation du langage de commande

49.1. Environnement

49.1.1. Configuration du fichier slapd.conf

49.1.2. Création de l’annuaire

49.1.3. Création de l’annuaire

49.1.4. Enrichissement de l’annuaire

49.1.5. Le langage de commande

50. L’annuaire LDAP

50.1. Authentification système LDAP sur un système GNU/Linux

50.1.1. Configuration de l’environnement pour l’authentification système

50.1.2. Premiers tests de l’annuaire

50.1.3. Vérification du fonctionnement de l’annuaire.

50.1.4. Mise en place de l’authentification

51. L’annuaire LDAP avec PHP

51.1. Utilisation de PHP avec LDAP

51.1.1. Les principales fonctions

51.1.2. Accès anonyme pour une recherche

51.1.3. Accès authentifié pour une recherche

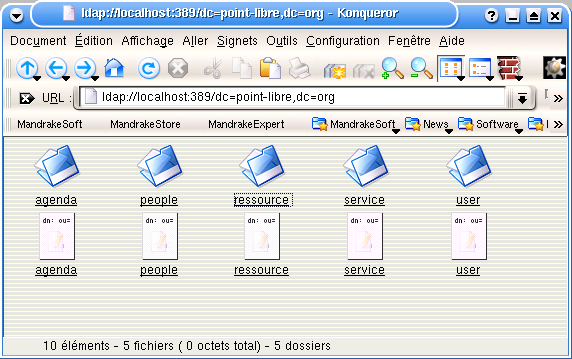

52. Annexes à la séquence sur LDAP

52.1. Exemple de fichier LDIF

52.2. L’annuaire ldap vu de konqueror

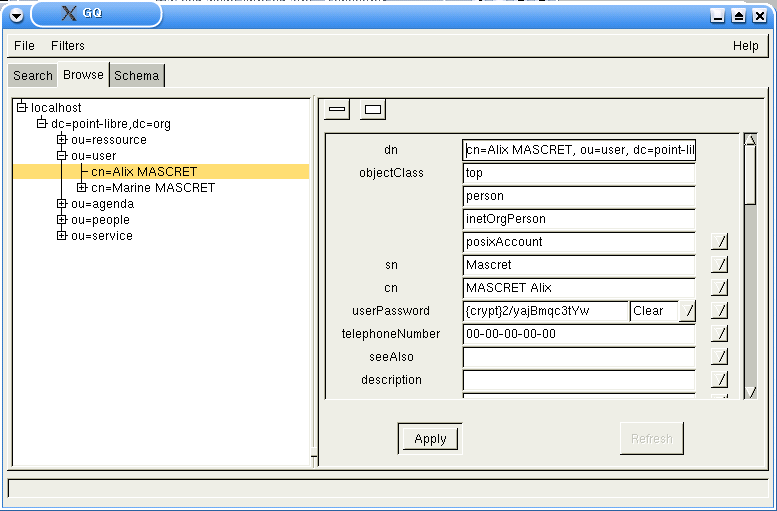

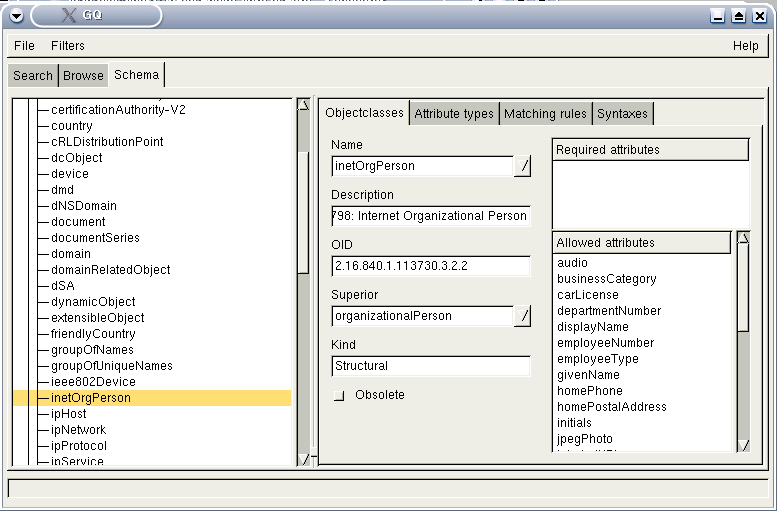

52.3. L’annuaire ldap vu de gq

52.4. Le schéma vu de gq

52.5. Authentification avec php sur LDAP

53. Planification prévisionnelle des séquences LDAP

53.1. Prévision des séquences

54. Synchroniser ses machines avec NTP

54.1. Introduction à ntpdate et ntpd

54.2. ntpdate

54.2.1. Installation de ntpdate

54.2.2. Configuration de ntpdate

54.3. ntpd

54.3.1. Installation de ntpd

54.3.2. Configuration de ntpd

54.4. Conclusion

54.5. Liens utiles

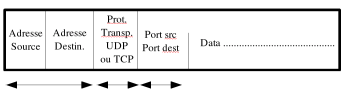

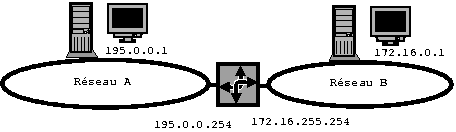

55. Eléments de cours sur le routage et le filtrage de paquets IP

55.1. Routage, Filtrage sur les paquets IP

55.2. Technique de masquage et de traduction d’adresse

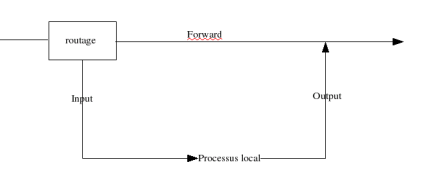

55.3. Masquerading et Forwarding

56. ICMP

56.1. ICMP et le filtrage de paquets

57. Ipchains

57.1. Langage d’Ipchains

58. Iptables

58.1. Langage d’Iptables

58.2. Exemples d’utilisation d’iptables

58.3. La traduction d’adresse – NAT

58.3.1. Le DNAT ou NAT Destination

58.3.2. Le SNAT ou NAT Source

58.3.3. L’IP Masquerade

58.3.4. Exemple sur un réseau privé

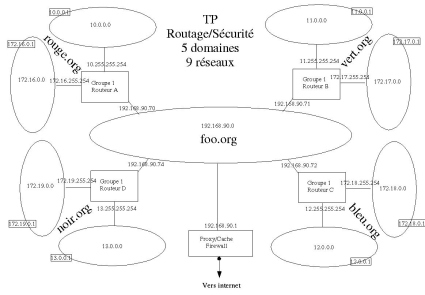

59. Application sur le routage et le filtrage de paquets IP

59.1. Introduction

59.2. Fonctions de filtrage

59.3. TD

59.4. Schéma de la maquette pour le TP

59.4.1. Première partie : installation et configuration du routage

59.4.2. Règles de filtrage simples

59.4.3. Règles de filtrage par adresse, port et protocoles

60. Outils et ressources complémentaires pour les TP

60.1. Iptraf

60.2. Documentations complémentaires

61. Initiation au routage

61.1. Initiation au routage

61.1.1. Les principes du routage

61.1.2. Place à la pratique

61.1.3. Conclusion

62. Le routage dynamique avec RIP

62.1. Introduction

62.1.1. Pourquoi le routage dynamique ?

62.1.2. Le protocole RIP

62.1.3. Place à la pratique

62.1.4. Conclusion

63. Le routage dynamique avec OSPF

63.1. Introduction

63.1.1. Rappels sur les éléments vus

63.1.2. Les grands principes

63.1.3. Le fonctionnement d’OSPF un peu plus en détail

63.1.4. Place à la pratique

63.1.5. Conclusion

64. Le routage dynamique avec BGP

64.1. Introduction

64.1.1. Les grands principes

64.1.2. Place à la pratique

64.1.3. Cohabitation entre BGP et les IGP

64.1.4. Conclusion

65. TP sur le routage statique avec Zebra

65.1. Introduction

65.1.1. Présentation des concepts importants

65.1.2. Architecture de Zebra

65.1.3. Topologie de travail

65.1.4. Mise en place

65.1.5. Démarrage du démon zebra

65.1.6. Connexion au démon zebra

65.1.7. Prise en main de Zebra (principe)

65.1.8. Prise en main de Zebra (mise en pratique)

65.1.9. Problèmes rencontrés

66. Multi-router looking glass

66.1. Présentation

67. Annexe sur le langage de commande de Zebra

67.1. Annexe sur le langage de commande de Zebra

68. Concepts généraux sur le routage

68.1. Présentation

68.2. Jargon réseau sur le routage

68.2.1. Notion de système autonome (SA)

68.2.2. Choix d’une route et métrique

68.3. Les protocoles de routages IGP’s

68.3.1. Les algorithmes Vector-Distance

68.3.2. Algorithme Link State (État de Liens)

68.3.3. Les techniques hybrides

68.4. Les protocoles de routages extérieurs EGP

69. Remerciements et licence

69.1. Copyright

Chapter 32. Travaux pratiques : configuration d’un système de messagerie

Les protocoles SMTP, POP et IMAP – TP

Les protocoles SMTP, POP et IMAP – TP

Comment installer un serveur SMTP, un client IMAP et un client POP3

Vous allez installer successivement :

- le serveur de messagerie postifx puis tester son fonctionnement,

- un serveur de remise de courrier pop3 et imap

- un client pop3 et imap puis tester son fonctionnement,

Pour imap on utilisera uw-imapd/uw-imapd-ssl, pour pop3, on utilisera ipopd. Pour les préconfigurer vous utiliserez les commandes :

dpkg-reconfigure uw-imapd

dpkg-reconfigure ipopd

Vous sélectionnerez pop3 et pop3/ssl, imap4 et imap/ssl. Attention pour imap4, c’est imap2 qu’il faut sélectionner. C’est bizarre mais c’est comme ça 😉 imap3 est devenu obsolète.

La procédure de configuration, génère des certificats dans /etc/ssl/certs/

32.2. DNS – préparation préalable

Vous allez déjà préparer votre serveur de nom. Le serveur de nom primaire sera également serveur SMTP (enregistrement MX – Mail eXchanger). Si votre serveur de nom s’appelle ns1, rajouter les enregistrements suivants dans le fichier de configuration de votre zone :

# On définit la machine qui achemine le courrier pour

# user@ns1.VotreDomaine.Dom

@ IN MX 10 ns1.VotreDomaine.Dom

#On définit un alias pour le courrier envoyé à

mail IN CNAME ns1

#On définit un alias pour le courrier envoyé à partir de

smtp IN CNAME ns1

#On définit un alias pour le serveur pop et pour imap

pop IN CNAME ns1

imap IN CNAME ns1

Relancer le service dns. Les commandes suivantes doivent fonctionner à partir d’un client du domaine :

ping ns1.VotreDomaine.Dom

ping smtp.VotreDomaine.Dom

ping mail.VotreDomaine.Dom

ping pop.VotreDomaine.Dom

ping imap.VotreDomaine.Dom

32.3. Configuration du serveur postifx.

Vous allez successivement configurer un serveur SMTP Postifx, tester la configuration, installer les serveur pop et imap, tester le fonctionnemnt de l’ensemble.

32.3.1. Installation du serveur SMTP

Configurer votre machine pour un service minimum (pas de liste, pas de réécriture d’adresse…).

Utilisez l’exemple de configuration de main.cf et la liste des variables à configurer donnés dans la fiche de cours, afin de mettre en place un service minimum.

Activez le service avec la commande /etc/init.d/postfix start. Vérifiez le bon démarrage du serveur dans le fichier de log et dans la table des processus (ps axf). Vous devriez obtenir quelque chose comme :

2745 ? S 0:00 /usr/lib/postfix/master

2748 ? S 0:00 \_ pickup -l -t fifo -c

2749 ? S 0:00 \_ qmgr -l -t fifo -u -c

2750 ? S 0:00 \_ tlsmgr -l -t fifo -u -c

Vérifiez également les traces dans le fichier de journalisation.

32.3.2. Test de la configuration du serveur SMTP

Créez sur la machine locale deux comptes systèmes pour les tests. cpt1 et cpt2 par exemple.

Ouvrez une session sous le compte cpt1 afin de réaliser un envoi de mail pour cpt2.

Lancez une transaction telnet VotreServeur 25, et réalisez un dialogue similaire à celui décrit en TD. Le message doit être délivré dans la boîte de cpt2. Utilisez la commande ps axf pour voir le chargement des différents démons.

Rélisez l’opération à l’aide du programme mail. Vérifiez que le message est bien délivré.

Avant de terminer la transaction, identifiez la session avec la commande netstat :

netstat -atup | grep ESTABLISHED

32.3.3. Installation du serveur PostOFFICE Pop3

La configuration du service pop est des plus simple. Il est même possible qu’il soit déjà actif. Décommentez la ligne dans le fichier /etc/inetd.conf ou utilisez dpkg-reconfigure.

Vérifier le fichier /etc/inetd.conf, relancez au besoin le service inetd.

# Pop and imap mail services

Avec xinet, la configuration est dans /etc/xinetd.d. Éditez les fichiers correspondant aux différents services. Par exemple le fichier /etc/xinetd.d/pop3s.

# default: off

# The POP3S service allows remote users to access their mail \

# using an POP3 client with SSL support such as fetchmail.

service pop3s

{

socket_type = stream

wait = no

user = root

server = /usr/sbin/ipop3d

log_on_success += USERID

log_on_failure += USERID

disable = no

}

Dans inetd.conf, décommentez la ligne. Dans xinetd, mettez la variable disable à no.

Relancer le service inetd ou xinetd, vérifiez l’ouverture des ports avec la commande netstat.

Identifiez les numéros de ports des services dans le fichier /etc/services.

Vous allez réaliser l’opération à partir de la machine locale et d’une machine distante. La résolution de nom doit fonctionner, sinon utilisez les adresses IP. Vous utiliserez kmail ou le client de messagerie de Mozilla.

- Sur la machine locale qui est votre serveur SMTP et serveur POP3, configurez le client de messagerie avec les paramètres suivants :

- Serveur smtp : Nom de votre serveur

- Serveur POP : Nom de votre serveur POP

- Votre compte d’utilisateur

- Votre mot de passe

Testez l’envoi et la réception de message.

Renseignez bien le numéro de port. Dans kmail, l’onglet extras vous donne accès à un bouton tester ce que le serveur peut gérer, et va vous renseigner sur le support de ssl ou tls du serveur.

Avec un client pop, les messages sont, par défaut, téléchargés depuis le serveur sur le client. La procédure supprime les fichiers téléchargés sur le serveur. Cette option est configurable sur la majorité des clients.

Vérifiez que les fichiers sont bien supprimés sur le serveur.

Réitérez l’envoi de message en mettant un fichier attaché (par exemple un fichier xls). Vérifier et relevez la description MIME du message.

- Sur un client configurez Nestcape Messenger avec les paramètres suivants :

- Serveur smtp : Nom de votre serveur (Machine distante)

- Serveur POP : Nom de votre serveur POP3 (Machine distante)

- Votre compte d’utilisateur

- Votre mot de passe

Testez l’envoi et la réception de message.

Identifiez les transactions dans le fichier de log.

Créez un compte utilisateur pn,

Créez un alias prenom.nom pour ce compte système dans le fichier /etc/aliases.

Mettez à jour le fichier /etc/aliases/db.

Vérifiez que les messages envoyés à :

pn@votredomaine ou prenom.nom@votredomaine doivent tous être correctement délivrés.

32.3.6. Utilisation des listes

Ouvrez à l’aide d’un éditeur le fichier /etc/aliases

Créez une liste de la façon suivante :

maliste: cpt1, cpt2

Enregistrez et régénérez le fichier aliases.db

Envoyez un message à maliste@foo.org, vérifiez que tous les membres de la liste ont bien reçu le message.

32.3.7. La gestion des erreurs

Certaines erreurs » systèmes » sont gérés par un compte particulier » MAILER_DAEMON « . Ce compte est en général un alias vers postmaster, qui, lui même redirige sur le compte de l’administrateur en fonction. Il agit commem un » robot » notamment quand un message ne peut être délivré.

Procédure de test

Envoyez un message à QuiNexistePas@foo.org

Relevez vos nouveau messages. Normalement, vous êtes averti que votre message n’a pas pu être délivré.

32.3.8. Mise en place du service IMAP sur le serveur

La mise en oeuvre est identique à celle du service Pop3. Configurer le fichier inetd.conf ou le fichier /etc/xinetd.d/imap. Relancer le service serveur (inetd ou xinetd).

Vous allez tester le bon fonctionnement de votre serveur : la commande ps aux | grep imap ne donne rien car le serveur imap est lancé » à la demande » par le serveur inetd ou xinetd.

Par contre la commande netstat -a | grep LISTEN | grep imap montre bien qu’un port est bien ouvert en » écoute « .

tcp 0 0 *:imap *:* LISTEN

Saisissez la commande telnet DeVotreServeurImap 143 pour activer le service imap. Le serveur doit répondre :

Trying 127.0.0.1…

Connected to localhost.

Escape character is ‘^]’.

* OK [CAPABILITY IMAP4 IMAP4REV1 STARTTLS LOGIN-REFERRALS AUTH=LOGIN]\

uranus.foo.org IMAP4rev1 2000.287rh at Sat, 17 Nov 2001 14:14:42 +0100 (CET)

Dans une autre session xterm, la commande ps aux | grep imap montre mainetant que le service est maintenant bien dans la liste des processus :

root 11551 0.0 1.1 3664 1448 ? S 14:14 0:00 imapd

et la commande ps axf

231 ? S 0:00 /usr/sbin/inetd

315 ? S 0:00 \_ imapd

montre bien que le processus imapd dépend (est fils de) inetd.

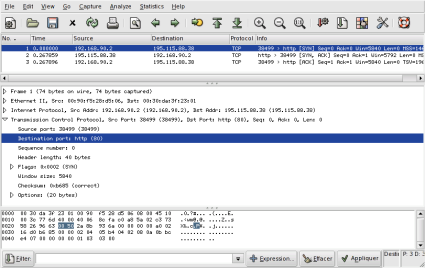

32.3.9. Plus loin dans le décryptage

La commande netstat a | grep imap donne l’état d’une connexion établie entre un client et le serveur.Socket client TCP sur le port 1024

tcp 0 0 *:imaps *:* LISTEN

tcp 0 0 *:imap2 *:* LISTEN

tcp 0 0 knoppix:imap2 knoppix:1025 ESTABLISHED

tcp 0 0 knoppix:1025 knoppix:imap2 ESTABLISHED

La commande fuser 1025/tcp utilise le pseudo-système de fichiers d’informations sur les processus /proc pour identifier » QUI » utilise la connexion tcp sur le port 1025.

root@knoppix:/home/knoppix# fuser 1025/tcp

1025/tcp: 364

La commande ls -l /proc/364 donne les indications sur le programme qui utilise cette connexion et montre que c’est une commande telnet qui a déclenché le processus.

root@knoppix:/home/knoppix# ls -al /proc/364

total 0

dr-xr-xr-x 3 knoppix knoppix 0 2003-04-16 15:06 .

dr-xr-xr-x 49 root root 0 2003-04-16 16:52 ..

-r–r–r– 1 knoppix knoppix 0 2003-04-16 15:06 cmdline

-r–r–r– 1 knoppix knoppix 0 2003-04-16 15:06 cpu

lrwxrwxrwx 1 knoppix knoppix 0 2003-04-16 15:06 cwd -> /home/knoppix

-r——– 1 knoppix knoppix 0 2003-04-16 15:06 environ

lrwxrwxrwx 1 knoppix knoppix 0 2003-04-16 15:06 \

exe -> /usr/bin/telnet-ssl

dr-x—— 2 knoppix knoppix 0 2003-04-16 15:06 fd

-r–r–r– 1 knoppix knoppix 0 2003-04-16 15:06 maps

-rw——- 1 knoppix knoppix 0 2003-04-16 15:06 mem

-r–r–r– 1 knoppix knoppix 0 2003-04-16 15:06 mounts

lrwxrwxrwx 1 knoppix knoppix 0 2003-04-16 15:06 root -> /

-r–r–r– 1 knoppix knoppix 0 2003-04-16 15:06 stat

-r–r–r– 1 knoppix knoppix 0 2003-04-16 15:06 statm

-r–r–r– 1 knoppix knoppix 0 2003-04-16 15:06 status

et voir la commande qui a activé cette connexion more /proc/364/cmdline qui retourne telnet localhost 143.

32.3.10. Mise en place du client IMAP

Utilisez Mail & NewsGroup de Mozilla ou kmail par exemple. Dans Mail & News Group, allez dans le menu de configuration (Edit) et ajoutez un compte. Prenez un compte imap.

Complétez la configuration de votre client de messagerie

Ouvrez l’application Messenger, testez l’utilisation du client IMAP.

Utiliser le » relayage » consiste pour un client A à utiliser le service serveur SMTP d’un domaine B pour inonder de messages (spammer) des boîtes aux lettres. Les serveurs sont généralement configurés pour empêcher le relayage. Dans Postifx, cette option est configurée par défaut.

Le relayage pose plusieurs problèmes. Remplissage des boîtes aux lettres sans l’accord des destinataires, utilisation des ressources disques et CPU à l’insu des sociétés qui relaient les courriers…

Afin de combattre un peu le phénomène, une société qui relai les messages peut se voir » black listée « , c’est-à-dire inscrite dans une liste noire référencée. Il existe plusieurs sites référençant ces listes noires. Certains de ces messages ne seront plus distribués. Voir pour cela, http://mail-abuse.org/rbl/, page principale de MAPS (Mail Abuse Prevention System LLC) RBLSM (Realtime Blackhole List).

Il est possible d’utiliser ces bases de données pour empêcher le relayage, ou refuser de délivrer les messages d’un site » black listé « .

maps_rbl_domains = rbl.maps.vix.com

maps_rbl_reject_code = 554

reject_maps_rbl

Vous allez activer la fonction de relayage sur votre serveur et tester son comportement. Modifiez la ligne :

relay_domains = $mydestination

par

relay_domains = $mydestination, domaine1.dom, domaine2.dom…

où domaine1.dom, domaine2.dom… représentent les différents domaines de votre salle de TP. Relancer les services serveurs.

Vous pouvez maintenant à partir d’un client, utiliser le serveur smtp d’un autre domaine pour vous en servir comme » agent de relai » et envoyer des messages aux utilisateurs des autres domaines.

32.3.12. Autres techniques de filtrage et autres services de postfix

Le fichier de configuration main.cf, permet de filtrer sur les entêtes de messages (grep) sous sur le contenu (body). Ces outils permettent dans certains cas de limiter le spam.

Le serveur postfix.org tient à jour des produits complémentaires qui permettent de mettre en place des antivirus, des outils de filtrage de spam ou des outils de type web-mail.

Chapter 33. Installation d’un serveur DDNS avec bind et DHCP

Le DNS dynamique

Le DNS dynamique

DHCP offre la possibilité de mettre à jour dynamiquement le système de résolution de nom.

Il s’agit, dans cette application, de faire cohabiter et faire fonctionner ensemble le service de résolution de nom bind et le service dhcp.

L’environnement a été testé sur une distribution debian, avec bind9 et dhcp3.

Vous devez savoir configurer un serveur DHCP, un serveur de nom, avoir compris le fonctionnement de rndc et des clés partagées, de dig.

Pour les amateurs d’ASCII-art, voici un schéma qui décrit les processus mis en oeuvre.

_______

| |_____________

| DHCP |_________ |

| | |3 |4

——- \|/ \|/

/|\| /|\| _______

| | | | | |

| | | | | DNS |

1|2| 5|6| | |

| | | | ——-

|\|/ |\|/

_______

| |

|Client |

| |

——-

(1) DHCPDISCOVER from 00:08:c7:25:bf:5a (saturne) via eth0

(2) DHCPOFFER on 192.168.0.195 to 00:08:c7:25:bf:5a (saturne) via eth0

(3) Added new forward map from saturne.freeduc-sup.org to 192.168.0.195

Ajout de l’enregistrement de type A

(4) added reverse map from 195.0.168.192.in-addr.arpa to saturne.freeduc-sup.org

Ajout de l’enregistrement de type PTR

(5) DHCPREQUEST for 192.168.0.195 (192.168.0.1) from 00:08:c7:25:bf:5a (saturne) via eth0

(6) DHCPACK on 192.168.0.195 to 00:08:c7:25:bf:5a (saturne) via eth0

Les opérations 1, 2, 5, 6 ont déjà été vues lors de l’étude du service DHCP. On voit en étudiant le » log » ci-dessus, que l’inscription dans le DNS d’un client se fait avant l’acceptation du bail et l’inscription finale de ce client (DHCPACK).

Dans cette application, vous installerez successivement le serveur de nom, le serveur dhcp, puis vous ferez les manipulations qui permettent l’intégration.

33.2. Éléments sur le service DDNS

Tout est décrit dans las pages de man de dhcpd.conf.

Deux façons de faire sont décrites (ad-hoc et interim) et une troisième est en cours d’élaboration. La méthode ad-hoc n’est semble t-il plus supportée par les paquets, du moins elle ne l’est pas avec le paquet dhcp3 de debian que j’utilise car considérée comme obsolète.

Le processus utilisé est défini par la variable ddns-updates-style. Si la mise à jour n’est pas dynamique, la variable prend la valeur none, nous, nous utiliserons interim.

La méthode » ad-hoc » ne prend pas en charge le protocole failover des DHCP. C’est à dire qu’avec cette méthode vous ne pourrez pas avoir 2 serveurs DHCP assurant un système redondant et mettant à jour un même ensemble d’enregistrements DNS.

Le serveur détermine le nom du client en regardant d’abord dans les options de configuration des noms (ddns-hostname). Il est possible de générer dynamiquement un nom pour le client en concaténant des chaînes » dyn+N°+NomDeDomaine « . S’il ne trouve rien, il regarde si le client lui a fait parvenir un nom d’hôte. Si aucun nom n’est obtenu, la mise à jour du DNS n’a pas lieu.

Pour déterminer le nom FQDN, le serveur concatène le nom de domaine au nom d’hôte du client.

Le nom du domaine lui, est défini uniquement sur le serveur DHCP.

Actuellement le processus ne prend pas en charge les clients ayant plusieurs interfaces réseau mais cela est prévu. Le serveur met à jour le DNS avec un enregistrement de type A et un enregistrement de type PTR pour la zone reverse. Nous verrons qu’un enregistrement de type TXT est également généré.

Quand un nouveau bail est alloué, le serveur crée un enregistrement de type TXT qui est une clé MD5 pour le client DHCP (DHCID).

La méthode interim est le standard. Le client peut demander au serveur DHCP de mettre à jour le serveur DNS en lui passant ses propres paramètres (nom FQDN). Dans ce cas le serveur est configuré pour honorer ou pas la demande du client. Ceci se fait avec le paramètre ignore client-updates ou allow client-updates.

Par exemple, si un client jschmoe.radish.org demande à être inscrit dans le domaine exemple.org et que le serveur DHCP est configuré pour, le serveur ajoutera un enregistrement PTR pour l’adresse IP mais pas d’enregistrement A. Si l’option ignore client-updates est configurée, il y aura un enregistrement de type A pour jschmoe.exemple.org.

33.3. Les aspects sur la sécurité

Le serveur DNS doit être configuré pour pouvoir être mis à jour par le serveur DHCP. La méthode la plus sûre utilise les signatures TSIG, basées sur une clé partagée comme pour le programme d’administration des serveurs de nom rndc.

Vous devrez en créer une. Pour cela utiliser les éléments fournis dans la partie traitant de bind. Ces aspects y ont déjà été abordés.

Par exemple dans le fichier named.conf, le serveur DHCP disposant de la clé DHCP_UPDATER, pourra mettre à jour la zone directe et la zone reverse pour lesquelles la déclaration allow-update existe.

Description du fichiers named.conf :

key DHCP_UPDATER {

algorithm HMAC-MD5.SIG-ALG.REG.INT;

secret pRP5FapFoJ95JEL06sv4PQ==;

};

zone « example.org » {

type master;

file « example.org.db »;

allow-update { key DHCP_UPDATER; };

};

zone « 17.10.10.in-addr.arpa » {

type master;

file « 10.10.17.db »;

allow-update { key DHCP_UPDATER; };

};

Dans le fichier de configuration du serveur DHCP vous pourrez mettre :

key DHCP_UPDATER {

algorithm HMAC-MD5.SIG-ALG.REG.INT;

secret pRP5FapFoJ95JEL06sv4PQ==;

};

zone EXAMPLE.ORG. {

primary 127.0.0.1; # Adresse du serveur de noms primaire

key DHCP_UPDATER;

}

zone 17.127.10.in-addr.arpa. {

primary 127.0.0.1; # Adresse du serveur de noms primaire

key DHCP_UPDATER;

}

La clé DHCP_UPDATER déclarée pour une zone dans le fichier dhcpd.conf est utilisée pour modifier la zone si la clé correspond dans le fichier named.conf.

Les déclarations de zone doivent correspondre aux enregistrement SOA des fichiers de ressources des zones.

Normalement il n’est pas obligatoire d’indiquer l’adresse du serveur de nom primaire, mais cela peut ralentir le processus d’inscription des enregistrements, voire même ne pas fonctionner, si le serveur de nom n’a pas répondu assez vite.

Chapter 34. Travaux pratiques : DDNS

Vous allez réaliser l’opération avec un client windows 2000 serveur et un client Linux. Le serveur Linux sera également serveur de nom.

Vous pouvez utiliser les exemples de fichiers fournis. Vosu aurez bien sûr à les adapter à votre configuration. Voici comment vont se dérouler les étapes :

- Installation du serveur de nom et test

- Installation du serveur DHCP et test

- Intégration des deux services

Nous verrons à la fin comment générer des noms dynamiquement pour les clients.

34.2. Les fichiers de configuration

Dans les fichiers il y a des lignes qui sont en commentaires avec ###, elles seront décommentées pour la phase d’intégration des services

// Pour journaliser, les fichiers doivent créés

logging {

channel update_debug {

file « /var/log/log-update-debug.log »;

severity debug 3;

print-category yes;

print-severity yes;

print-time yes;

};

channel security_info {

file « /var/log/log-named-auth.info »;

severity info;

print-category yes;

print-severity yes;

print-time yes;

};

category update { update_debug; };

category security { security_info; };

};

// clé partagée entre bind, rndc et dhcp

include « /etc/bind/mykey »;

options {

directory « /var/cache/bind »;

query-source address * port 53;

auth-nxdomain yes; # conform to RFC1035

forwarders { 127.0.0.1; 192.168.0.1;};

};

// Autorisations rndc sur la machine.

controls {

inet 127.0.0.1 allow {any;} keys {mykey;};

inet 192.168.0.0 allow {any;} keys {mykey;};

};

zone « . » {

type hint;

file « /etc/bind/db.root »;

};

zone « localhost » {

type master;

file « /etc/bind/db.local »;

};

zone « 127.in-addr.arpa » {

type master;

file « /etc/bind/db.127 »;

};

zone « 0.in-addr.arpa » {

type master;

file « /etc/bind/db.0 »;

};

zone « 255.in-addr.arpa » {

type master;

file « /etc/bind/db.255 »;

};

zone « freeduc-sup.org » {

type master;

file « /etc/bind/freeduc-sup.org.hosts »;

// Sert à la mise à jour par DHCP

// Sera décommenté lors de l’intégration des services

### allow-update { key mykey; };

};

zone « 0.168.192.in-addr.arpa » {

type master;

file « /etc/bind/freeduc-sup.org.hosts.rev »;

// Sert à la mise à jour par DHCP

// Sera décommenté lors de l’intégration des services

### allow-update { key mykey; };

};

34.2.2. Le fichier de zone directe

$ORIGIN .

$TTL 86400 ; 1 day

freeduc-sup.org IN SOA master.freeduc-sup.org. root.freeduc-sup.org. (

2004050103 ; serial

10800 ; refresh (3 hours)

3600 ; retry (1 hour)

604800 ; expire (1 week)

38400 ; minimum (10 hours 40 minutes)

)

NS master.freeduc-sup.org.

MX 10 master.freeduc-sup.org.

$ORIGIN freeduc-sup.org.

master A 192.168.0.1

www CNAME master

34.2.3. Le fichier de zone in-addr.arpa

$ORIGIN .

$TTL 86400 ; 1 day

0.168.192.in-addr.arpa IN SOA master.freeduc-sup.org. root.freeduc-sup.org. (

2004050103 ; serial

10800 ; refresh (3 hours)

3600 ; retry (1 hour)

604800 ; expire (1 week)

38400 ; minimum (10 hours 40 minutes)

)

NS master.freeduc-sup.org.

$ORIGIN 0.168.192.in-addr.arpa.

1 PTR master.freeduc-sup.org.

include « /etc/bind/mykey »;

options {

default-server localhost;

default-key « mykey »;

};

server localhost {

key « mykey »;

};

34.2.5. Le fichier de clé partagée

Ici il est nommé mykey.

key « mykey » {

algorithm hmac-md5;

secret « X/ErbPNOiXuC8MIgTX6iRcaq/1OFCEDIlxrmnfPgdqYIOY3U6lsgDMq15jnxXEXmdGvv1g/ayYtAA73bUQvWBw== »;

};

ddns-update-style none;

### ddns-update-style interim;

### deny client-updates;

### ddns-updates on;

### ddns-domainname « freeduc-sup.org »;

### ddns-rev-domainname « in-addr.arpa »;

authoritative;

subnet 192.168.0.0 netmask 255.255.255.0 {

option broadcast-address 192.168.0.255;

option routers 192.168.0.2;

option domain-name « freeduc-sup.org »;

option domain-name-servers 192.168.0.1;

option broadcast-address 192.168.0.255;

option routers 192.168.0.2;

range 192.168.0.100 192.168.0.195;

default-lease-time 600;

max-lease-time 7200;

# Instructions pour la mise à jour des zones

### include « /etc/bind/mykey »;

### zone freeduc-sup.org. {

### primary 192.168.0.1;

### key mykey;

### }

### zone 0.168.192.in-addr.arpa. {

### primary 192.168.0.1;

### key mykey;

### }

}

34.3. Procédure de tests des services

Vous allez pouvoir tester. À partir de maintenant vous devrez consulter les fichiers de logs si vous rencontrez des problèmes de fonctionnement, les tables de processus… bref tout ce qui pourra vous permettre de déterminer la ou les sources possibles des dysfonctionnements si vous en constatez.

Lancez le service bind et tester son fonctionnement avec rndc.

root@master:/home/knoppix# rndc status

number of zones: 8

debug level: 0

xfers running: 0

xfers deferred: 0

soa queries in progress: 0

query logging is OFF

server is up and running

root@master:/home/knoppix#

Ça permet de vérifier que la clé est bien reconnue.

Vérifiez le fonctionnement du serveur à l’aide de la commande dig.

root@master:/home/knoppix/tmp# dig @127.0.0.1 freeduc-sup.org axfr

; <<>> DiG 9.2.2 <<>> @127.0.0.1 freeduc-sup.org axfr

;; global options: printcmd

freeduc-sup.org. 86400 IN SOA master.freeduc-sup.org. root.freeduc-sup.org. 2004050107 10800 3600 604800 38400

freeduc-sup.org. 86400 IN NS master.freeduc-sup.org.

freeduc-sup.org. 86400 IN MX 10 master.freeduc-sup.org.

argo.freeduc-sup.org. 86400 IN A 192.168.0.253

master.freeduc-sup.org. 86400 IN A 192.168.0.1

www.freeduc-sup.org. 86400 IN CNAME master.freeduc-sup.org.

freeduc-sup.org. 86400 IN SOA master.freeduc-sup.org. root.freeduc-sup.org. 2004050107 10800 3600 604800 38400

;; Query time: 36 msec

;; SERVER: 127.0.0.1#53(127.0.0.1)

;; WHEN: Tue May 6 19:15:38 2003

;; XFR size: 8 records

Vérifier de la même façon le fonctionnement de la zone reverse.

Vérifiez la strucure du fichier dhcp.

root@master:/home/knoppix# dhcpd3 -t

Internet Software Consortium DHCP Server V3.0.1rc9

Copyright 1995-2001 Internet Software Consortium.

All rights reserved.

For info, please visit http://www.isc.org/products/DHCP

Ça permet de vérifier qu’il n’y a pas d’erreur de syntaxe dans le fichier.

Testez le fonctionnement traditionnel de votre serveur DHCP à partir d’un client Linux et windows. Faites des renouvellement de baux.

34.4. Intégration des services

Par défaut les client Linux ne transmettent pas leur nom d’hôte comme c’est le cas pour les clients windows. Modifiez sur le client Linux le fichier /etc/dhclient.conf de la façon suivante, nous verrons plus loin comment générer un nom dynamiquement :

[root@bestof mlx]# more /etc/dhclient.conf

send host-name « bestof »;

Décommentez dans les fichiers named.conf et dhcpd.conf les lignes commentées par ###.

Supprimez dans le dhcpd.conf la ligne :

ddns-update-style none;

Relancez le service DNS et testez sont bon fonctionnement

Vérifiez le fichier dhcpd.conf avec la commande dhcpd3 -t.

Lancez dhcp en mode foreground dhcpd3 -d, voici ce que vous devriez obtenir :

root@master:/etc/dhcp3# dhcpd3 -d

Internet Software Consortium DHCP Server V3.0.1rc9

Copyright 1995-2001 Internet Software Consortium.

All rights reserved.

For info, please visit http://www.isc.org/products/DHCP

Wrote 1 leases to leases file.

Listening on LPF/eth0/00:d0:59:82:2b:86/192.168.0.0/24

Sending on LPF/eth0/00:d0:59:82:2b:86/192.168.0.0/24

Sending on Socket/fallback/fallback-net

Demandez un bail à partir du client windows (ici windows 2000 Server), voici ce qui devrait se passer :

DHCPDISCOVER from 00:08:c7:25:bf:5a (saturne) via eth0

DHCPOFFER on 192.168.0.195 to 00:08:c7:25:bf:5a (saturne) via eth0

Added new forward map from saturne.freeduc-sup.org to 192.168.0.195

added reverse map from 195.0.168.192.in-addr.arpa to saturne.freeduc-sup.org

DHCPREQUEST for 192.168.0.195 (192.168.0.1) from 00:08:c7:25:bf:5a (saturne) via eth0

DHCPACK on 192.168.0.195 to 00:08:c7:25:bf:5a (saturne) via eth0

Demandez un bail à partir du client Linux, voici ce qui devrait se passer :

DHCPDISCOVER from 00:08:c7:25:ca:7c via eth0

DHCPOFFER on 192.168.0.194 to 00:08:c7:25:ca:7c (bestof) via eth0

Added new forward map from bestof.freeduc-sup.org to 192.168.0.194

added reverse map from 194.0.168.192.in-addr.arpa to bestof.freeduc-sup.org

DHCPREQUEST for 192.168.0.194 (192.168.0.1) from 00:08:c7:25:ca:7c (bestof) via eth0

DHCPACK on 192.168.0.194 to 00:08:c7:25:ca:7c (bestof) via eth0

Voici le contenu du fichier de journalisation de bind :

Log de Bind log-update-debug.log

root@master:/var/log# more log-update-debug.log

May 06 07:49:50.457 update: info: client 192.168.0.1#32846: updating zone ‘freeduc-sup.org/IN’: adding an RR

May 06 07:49:50.458 update: info: client 192.168.0.1#32846: updating zone ‘freeduc-sup.org/IN’: adding an RR

May 06 07:49:50.512 update: info: client 192.168.0.1#32846: updating zone ‘0.168.192.in-addr.arpa/IN’: deleting an rrse

t

May 06 07:49:50.512 update: info: client 192.168.0.1#32846: updating zone ‘0.168.192.in-addr.arpa/IN’: adding an RR

May 06 07:50:47.011 update: info: client 192.168.0.1#32846: updating zone ‘freeduc-sup.org/IN’: adding an RR

May 06 07:50:47.011 update: info: client 192.168.0.1#32846: updating zone ‘freeduc-sup.org/IN’: adding an RR

May 06 07:50:47.017 update: info: client 192.168.0.1#32846: updating zone ‘0.168.192.in-addr.arpa/IN’: deleting an rrse

t

May 06 07:50:47.017 update: info: client 192.168.0.1#32846: updating zone ‘0.168.192.in-addr.arpa/IN’: adding an RR

root@master:/var/log#

Voici le contenu du fichier de déclaration de zone avec les nouveaux enregistrements

root@master:/var/log# dig @127.0.0.1 freeduc-sup.org axfr

; <<>> DiG 9.2.2 <<>> @127.0.0.1 freeduc-sup.org axfr

;; global options: printcmd

freeduc-sup.org. 86400 IN SOA master.freeduc-sup.org. root.freeduc-sup.org. 2004050103 10800 3600 604800 38400

freeduc-sup.org. 86400 IN NS master.freeduc-sup.org.

freeduc-sup.org. 86400 IN MX 10 master.freeduc-sup.org.

argo.freeduc-sup.org. 86400 IN A 192.168.0.253

bestof.freeduc-sup.org. 300 IN TXT « 00e31b2921cd30bfad552ca434b61bda02 »

bestof.freeduc-sup.org. 300 IN A 192.168.0.194

master.freeduc-sup.org. 86400 IN A 192.168.0.1

saturne.freeduc-sup.org. 300 IN TXT « 310e43cfc20efbe1c96798d48672bc76aa »

saturne.freeduc-sup.org. 300 IN A 192.168.0.195

www.freeduc-sup.org. 86400 IN CNAME master.freeduc-sup.org.

freeduc-sup.org. 86400 IN SOA master.freeduc-sup.org. root.freeduc-sup.org. 2004050103 10800 3600 604800 38400

;; Query time: 381 msec

;; SERVER: 127.0.0.1#53(127.0.0.1)

;; WHEN: Tue May 6 07:56:43 2003

;; XFR size: 12 records

34.5. Générer un nom dynamiquement pour les clients DHCP

Cela est possible en modifiant le fichier de configuration de DHCP. Vous pourrez retrouver tous les éléments dans la page de manuel.

Par exemple rajoutez dans le fichier la ligne ci-dessous pour adapter le nom à partir de l’adresse MAC du client :

#ddns-hostname = binary-to-ascii (16, 8, « -« ,substring (hardware, 1, 12));

Ou celle-ci pour localiser le client :

ddns-hostname = concat (« dhcp-a-limoges », »-« ,binary-to-ascii(10,8, »-« ,leased-address));

Avec cette dernière, voici les enregistrements ajoutés :

Added new forward map from dhcp-a-limoges-192-168-0-194.freeduc-sup.org to 192.168.0.194

added reverse map from 194.0.168.192.in-addr.arpa to dhcp-a-limoges-192-168-0-194.freeduc-sup.org

DHCPREQUEST for 192.168.0.194 from 00:08:c7:25:ca:7c via eth0

DHCPACK on 192.168.0.194 to 00:08:c7:25:ca:7c (bestof) via eth0

Le fichier des incriptions :

root@master:/home/knoppix# more /var/lib/dhcp3/dhcpd.leases

lease 192.168.0.194 {

starts 2 2003/05/06 17:38:38;

ends 2 2003/05/06 17:48:38;

binding state active;

next binding state free;

hardware ethernet 00:08:c7:25:ca:7c;

set ddns-rev-name = « 194.0.168.192.in-addr.arpa »;

set ddns-txt = « 00e31b2921cd30bfad552ca434b61bda02 »;

set ddns-fwd-name = « dhcp-192-168-0-194.freeduc-sup.org »;

client-hostname « bestof »;

}

Les transferts de zones directes et inverses :

root@master:/home/knoppix/tmp# dig @127.0.0.1 freeduc-sup.org axfr

; <<>> DiG 9.2.2 <<>> @127.0.0.1 freeduc-sup.org axfr

;; global options: printcmd

freeduc-sup.org. 86400 IN SOA master.freeduc-sup.org. root.freeduc-sup.org. 2004050116 10800 3600 604800 38400

freeduc-sup.org. 86400 IN NS master.freeduc-sup.org.

freeduc-sup.org. 86400 IN MX 10 master.freeduc-sup.org.

0-8-c7-25-ca-7c.freeduc-sup.org. 300 IN TXT « 00e31b2921cd30bfad552ca434b61bda02 »

0-8-c7-25-ca-7c.freeduc-sup.org. 300 IN A 192.168.0.194

argo.freeduc-sup.org. 86400 IN A 192.168.0.253

dhcp-192-168-0-194.freeduc-sup.org. 300 IN TXT « 00e31b2921cd30bfad552ca434b61bda02 »

dhcp-192-168-0-194.freeduc-sup.org. 300 IN A 192.168.0.194

dhcp-a-limoges-192-168-0-194.freeduc-sup.org. 300 IN TXT « 00e31b2921cd30bfad552ca434b61bda02 »

dhcp-a-limoges-192-168-0-194.freeduc-sup.org. 300 IN A 192.168.0.194

master.freeduc-sup.org. 86400 IN A 192.168.0.1

www.freeduc-sup.org. 86400 IN CNAME master.freeduc-sup.org.

freeduc-sup.org. 86400 IN SOA master.freeduc-sup.org. root.freeduc-sup.org. 2004050116 10800 3600 604800 38400

;; Query time: 3 msec

;; SERVER: 127.0.0.1#53(127.0.0.1)

;; WHEN: Tue May 6 19:39:08 2003

;; XFR size: 14 records

La zone reverse :

root@master:/home/knoppix/tmp# dig @127.0.0.1 0.168.92.in-addr.arpa axfr

; <<>> DiG 9.2.2 <<>> @127.0.0.1 0.168.92.in-addr.arpa axfr

;; global options: printcmd

; Transfer failed.

root@master:/home/knoppix/tmp# dig @127.0.0.1 0.168.192.in-addr.arpa axfr

; <<>> DiG 9.2.2 <<>> @127.0.0.1 0.168.192.in-addr.arpa axfr

;; global options: printcmd

0.168.192.in-addr.arpa. 86400 IN SOA master.freeduc-sup.org. root.freeduc-sup.org. 2004050113 10800 3600 604800 38400

0.168.192.in-addr.arpa. 86400 IN NS master.freeduc-sup.org.

1.0.168.192.in-addr.arpa. 86400 IN PTR master.freeduc-sup.org.

194.0.168.192.in-addr.arpa. 300 IN PTR dhcp-192-168-0-194.freeduc-sup.org.

3.0.168.192.in-addr.arpa. 86400 IN PTR argo.freeduc-sup.org.

0.168.192.in-addr.arpa. 86400 IN SOA master.freeduc-sup.org. root.freeduc-sup.org. 2004050113 10800 3600 604800 38400

;; Query time: 3 msec

;; SERVER: 127.0.0.1#53(127.0.0.1)

;; WHEN: Tue May 6 19:40:08 2003

;; XFR size: 7 records

Chapter 35. Installation d’un service Web-mail

Agent Utilisateurs de Messagerie basés sur HTTP

Agent Utilisateurs de Messagerie basés sur HTTP

Il est préférable d’avoir réalisé les ateliers sur les serveurs HTTP, SMTP et DNS avant de commencer celui-ci.

Le service Web-mail permet l’utilisation d’un service de messagerie à partir d’un client Web comme mozilla. Cette interface est intéressante, car contrairement à un client pop3 standard qui serait configuré pour rapatrier les courriers sur la machine locale, ceux-ci, vont rester sur le serveur. Vous pouvez les consulter à partir de n’importe quel poste pourvu qu’il dispose d’un navigateur. Vous aurez ensuite tout le loisir de les récupérer avec votre client de messagerie préféré si vous en utilisez un.

Il existe un très grand nombre de serveur Web-mail, et écris dans des langages très différents. Une étude a été réalisée par le CRU http://www.cru.fr/http-mail/, mais parmi les principaux on peut citer IMP écris en PHP et qui s’appuie sur la librairie horde. Il existe aussi OpenWebmail qui lui est écris en Perl. Ces deux produits existent en paquets Debian, on utilisera pour le TP OpenWebmail, mais ces deux outils comportent chacun de nombreuses qualités, le choix devra se faire en fonction du degré d’intégration que vous souhaiterez obtenir avec vos autres applications.

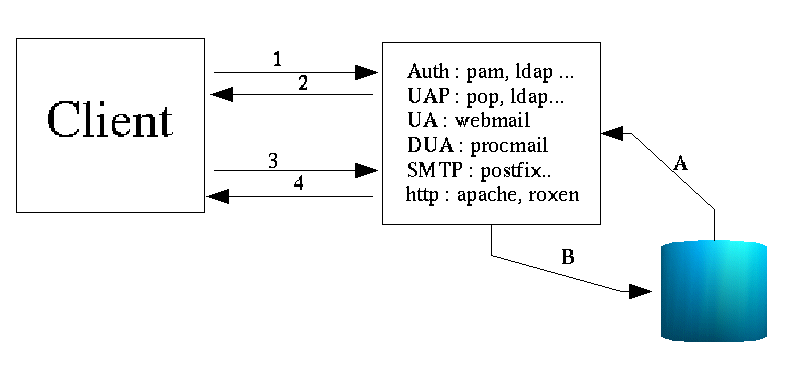

35.2. Architecture générale du service

Figure 35-1. Architecture globale d’un service Web-mail

- En 1 et 2, le client passe par une phase préalable d’authentification, il faut donc un service correspondant sur le serveur. Cela peut être pris directement en charge par le service Web-mail ou par un service extérieur (pam, ldap par exemple). (Nous utiliserons l’authentification pam).

- En 3 et 4, le dialogue s’effectue en un navigateur et un serveur HTTP. Le dialogue peut s’effectuer dans un canal SSL ou TLS. Le suivi de session peut être réalisé à l’aide de cookie par exemple. (Nous utiliserons Apache comme serveur HTTP).

- En A et B, le service Web-mail utilise une base de données pour les boîtes aux lettres des utilisateurs, pour les dossiers (inbox, outbox, trash…) et la conservation des courriers. Certains Web-mail s’appuient sur des bases de type MySQL, PostgreSQL… ou simplement sur une arborescence de répertoires dans le HOME_DIRECTORY de l’utilisateur. (Nous n’utiliserons pas de SGBD/R).

- Sur le serveur, il faut activer un protocole de traitement du courrier (pop3, pop3s, imap, imaps…). Nous utiliserons imap et pop3.

- Vous aurez également besoin d’un service SMTP pour le traitement des courriers sortants (nous utiliserons postfix) et d’un service de livraison (DUA) (nous utiliserons procmail) pour délivrer les courriers entrants.

35.3. Installation et configuration OpenWebmail

Vous allez installer OpenWebmail mais auparavant il est nécessaire de s’assurer du bon fonctionnement de certains services. (smtp, mail, procmail, apache…)

35.3.1. Préparation de la machine

Suivez la procédure ci-dessous pour préparer la machine.

35.3.1.1. Configuration générale

On considère la configuration suivante, vous adapterez les noms, adresses IP et autres paramètres à votre configuration. Il n’y a pas de DNS.

Nom d’hôte : freeduc-sup ($NAME)

Nom FQDN de la machine : freeduc-sup.foo.org ($FQDN)

Adresse de réseau : 192.168.0.0

Adresse de la machine : 192.168.0.2

Adresse de la passerelle par défaut : 192.168.0.254

35.3.1.2. Test de la résolution de nom

Vérifier que la résolution de nom fonctionne parfaitement. Les commandes : ping $NAME et ping $FQDN doivent répondre correctement.

# Exemple de fichier /etc/hosts

127.0.0.1 freeduc-sup freeduc-sup.foo.org localhost localhost.localdomain

192.168.0.2 freeduc-sup freeduc-sup.foo.or

Activez le service apache. Il ne doit pas y avoir de message d’erreur au lancement, notamment sur la résolution de nom. Vérifiez également le bon fonctionnement avec une requête sur : http://localhost

35.3.1.4. Le service SMTP (Postfix)

Pour configurer postfix, utilisez la commande dpkg-reconfigure postfix, vous prendrez site internet. Les valeurs par défaut doivent normalement fonctionner.

Ouvrez le fichier /etc/postfix/main.cf, vérifiez qu’il correspond à celui-ci, au besoin modifiez le :

# Fichier de configuration de Postfix

# Adaptez vos noms d’hôtes et vos noms de machines

# see /usr/share/postfix/main.cf.dist for a commented, fuller

# version of this file.

# Do not change these directory settings – they are critical to Postfix

# operation.

command_directory = /usr/sbin

daemon_directory = /usr/lib/postfix

program_directory = /usr/lib/postfix

smtpd_banner = $myhostname ESMTP $mail_name (Debian/GNU)

setgid_group = postdrop

biff = no

myhostname = freeduc-sup.foo.org

mydomain = foo.org

myorigin = $myhostname

inet_interfaces = all

alias_maps = hash:/etc/aliases

alias_database = hash:/etc/aliases

mydestination = $myhostname, localhost.$mydomain

relayhost =

mailbox_command = procmail -a « $EXTENSION »

mailbox_size_limit = 0

recipient_delimiter = +

Une fois cela réalisé, activez ou relancez le service.

/etc/init.d/postfix start

/etc/init.d/postfix reload

35.3.1.5. Activation des services imap

Cela s’effectue dans le fichier inet.conf. Il faudra adapter si vous utilisez xinetd. Cela dépend de la distribution de GNU/Linux que vous utilisez. Vous pouvez également utiliser la commande dpkg-reconfigure uw-imapd. Dans ce cas, prenez imap2 (qui correspond à imap4 (? ;-))) et imaps.

Extrait d’un exemple de configuration de inetd.conf :

#:MAIL: Mail, news and uucp services.

imap2 stream tcp nowait root /usr/sbin/tcpd /usr/sbin/imapd

Adaptez votre fichier de configuration, puis relancer inetd avec la commande :

/etc/init.d/inetd restart

Vérifiez que les ports sont bien ouverts avec la commande netstat. Vous devez avoir les ports 25 (pop3)si vous l’avez activé et 143 (imap) ouverts.

netstat -atup | grep LISTEN

tcp 0 0 *:netbios-ssn *:* LISTEN 269/smbd

tcp 0 0 *:imap2 *:* LISTEN 263/inetd

tcp 0 0 *:sunrpc *:* LISTEN 151/portmap

tcp 0 0 *:ssh *:* LISTEN 278/sshd

tcp 0 0 *:ipp *:* LISTEN 290/cupsd

tcp 0 0 *:smtp *:* LISTEN 899/master

Nous voyons imap2, ligne 2, pris en charge par inetd.

root@freeduc-sup:/home/mlx# netstat -natup | grep LISTEN

tcp 0 0 0.0.0.0:139 0.0.0.0:* LISTEN 269/smbd

tcp 0 0 0.0.0.0:143 0.0.0.0:* LISTEN 263/inetd

tcp 0 0 0.0.0.0:111 0.0.0.0:* LISTEN 151/portmap

tcp 0 0 0.0.0.0:22 0.0.0.0:* LISTEN 278/sshd

tcp 0 0 0.0.0.0:631 0.0.0.0:* LISTEN 290/cupsd

tcp 0 0 0.0.0.0:25 0.0.0.0:* LISTEN 899/master

Ici l’option -n de netstat nous indique les numéros de ports utilisés.

Remarque : si vous souhaitez utiliser un client pop, vous devrez activer également le protocole pop.

À ce stade, il nous est possible de tester complètement le service de messagerie. Vous pouvez indifféremment utiliser un client comme kmail ou Mozilla. Le plus simple est d’utiliser le client mail.

Suivez la procédure ci-dessous :

- Créez deux comptes utilisateurs alpha et beta qui serviront pour les tests avec la commande adduser.

- Testez avec la commande mail que l’envoie de courrier se déroule correctement. Les commandes :

- mail alpha

- mail alpha@freeeduc-sup

- mail alpha@freeduc-sup.foo.org

doivent fonctionner correctement.

35.3.2. Installation d’OpenWebmail

Si vous utilisez la freeduc-sup, OpenWebmail n’est pas installé. Utilisez la commande :

apt-get install openwebmail

La commande installera également 3 paquets supplémentaires qui correspondent aux dépendances puis lancera la procédure de configuration.

35.3.3. Configuration de l’application OpenWebmail

Vous pouvez à tout moment reconfigurer l’application avec dpkg-reconfigure openwebmail. Prenez comme option :

authentification -> auth_pam.pl

langage -> fr

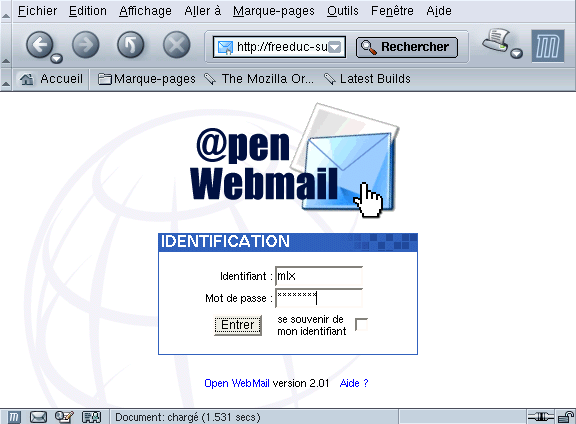

35.3.4. Test de l’environnement

Pour tester l’environnement vous avez deux liens :

http://localhost/openwebmail

qui vous place sur un espace documentaire

http://localhost/cgi-bin/openwebmail/openwebmail.pl

qui lance l’application proprement dite et vous amène sur la première fenêtre de login

Figure 35-2. Ouverture de session sur un Web-mail

Il vous sera possible de créer un serveur Web virtuel pour avoir par exemple : » openwebmail.freeduc-sup.org « .

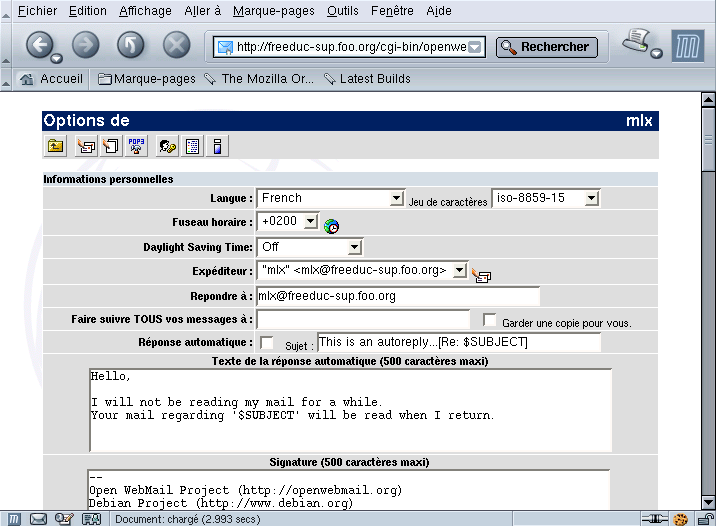

35.3.5. Configuration de l’environnement utilisateur

À la première session, la personne reçoit une invite lui permettant de configurer son environnement et ses paramètres particuliers, comme son adresse de réponse, modifier son mot de passe… Ces paramètres sont modifiables à tout moment.

Figure 35-3. Configuration de l’environnement utilisateur

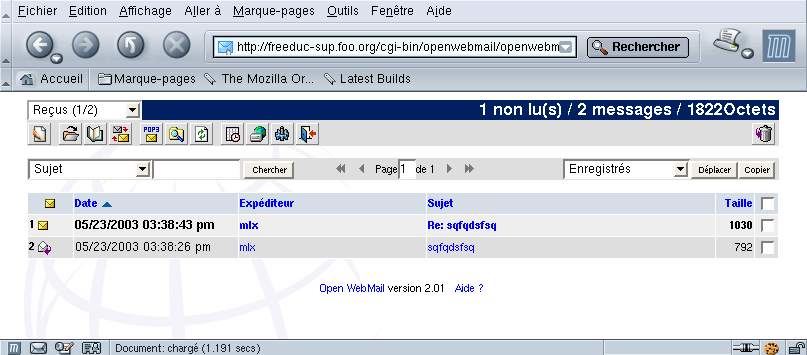

35.3.6. Test et environnement OpenWebmail

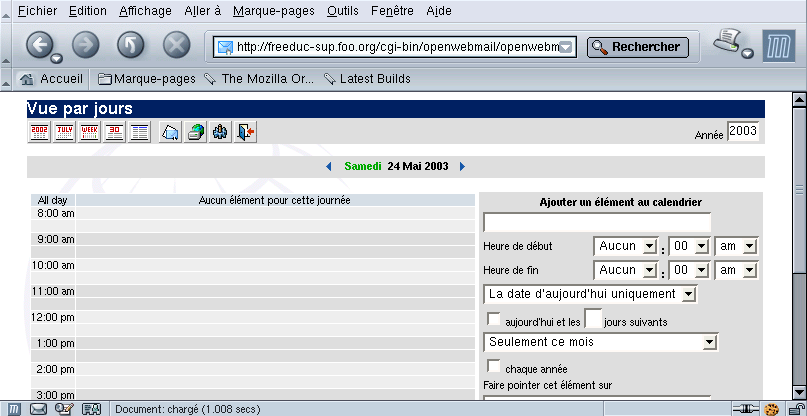

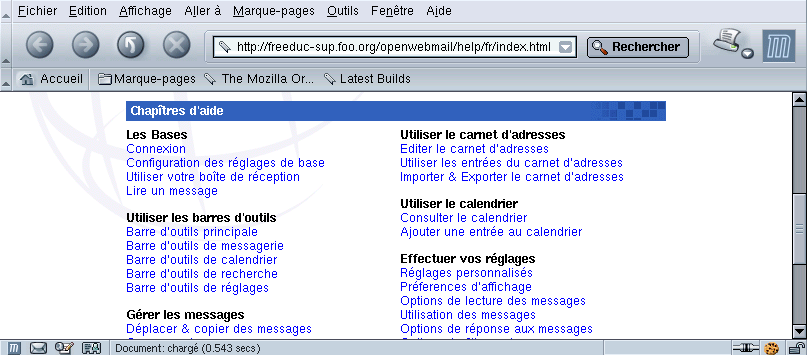

À partir de ce moment, l’environnement complet est disponible. L’utilisateur dispose également d’un calendrier et d’une documentation en ligne.

Figure 35-4. Voir ses messages

- Configurez et vérifiez le bon fonctionnement des services de résolution de nom, apache, postfix.

- Installez et configurez OpenWebmail.

- Testez le fonctionnement OpenWebmail.

Chapter 36. Installation d’un service mandataire (Proxy SQUID)

Serveur mandataire et serveur de cache – Fiche de cours

Serveur mandataire et serveur de cache – Fiche de cours

Squid est un service serveur proxy-cache sous linux. Les objets consultés par les clients sur internet, sont stockés en cache disque par le serveur. À partir du deuxième accès, la lecture se fera en cache, au lieu d’être réalisée sur le serveur d’origine. De ce fait il permet » d’accélérer » vos connexions à l’internet en plaçant en cache les documents les plus consultés. On peut aussi utiliser la technique du service serveur mandataire pour effectuer des contrôles d’accès aux sites.

Les services proxy peuvent être organisés de façon hiérarchique :

________

|serveur |

|national|

|________|

|

________|________

| |

___|____ ___|____

|serveur | |serveur |

|régional| |régional|

|________| |________|

|

______|______

| |

____|___ ____|___

|serveur | |serveur |

| local | | local |

|________| |________|

Ls serveurs peuvent être paramétrés pour les autorisations d’accès et les synchronisations.

Les postes clients sont souvent configurés pour utiliser un serveur proxy. Le client s’adresse au serveur proxy, et c’est ce dernier qui traite la requête sur internet. Un fois la réponse reçue, le serveur met en cache la réponse et la retourne au client interne. Le service proxy est fréquemment configuré sur un routeur qui remplit aussi le service de translation d’adresse ou translation de port, mais toutes ces fonctions sont bien différentes.

Dans certains cas, on peut ne pas souhaiter que la configuration soit réalisée au niveau du client. On souhaite que celle-ci soit faite au niveau du serveur. Cela peut arriver par exemple si vous avez plusieurs centaines de postes à configurer ou bien si vous ne souhaitez pas que les utilisateurs puissent modifier ou avoir accès à cette partie de la configuration. On parlera de » service proxy transparent « >. Le service serveur proxy peut être sur le routeur d’accès à l’internet ou sur une autre machine.

Service proxy tranparent :

La configuration des navigateurs, sur les postes clients, n’est pas concernée.

Vers internet

/|\ /|\

| |

___|____ ____|____ ________

|routeur | | | (3) | |

| proxy | | routeur | <—– | proxy |

|________| |_________| ——> |________|

| /|\ (2)

______|______ |

| | | (1)

____|___ ____|___ ____|____

| | | | | |

| client | | client | | client |

|________| |________| |_________|

<———————-> <—————————–>

Figure 1 Figure 2

Sur la Figure 1, le service proxy est installé sur le routeur.

Sur la figure 2, les requêtes du client (1), sont redirigées vers le proxy par le routeur (2), qui retourne au client la réponse ou redirige vers le routeur (3) pour un envoi sur l’extérieur.

Sur debian apt-get install squid.

Squid comporte de très nombreux paramètres. L’optimisation n’en est pas toujours simple. Nous allons voir uniquement quelques options permettant un fonctionnement du service. Il sera nécessaire, pour un site en production, de se référer à la documentation officielle.

Pour démarrer une configuration simple, il est possible d’utiliser le fichier de configuration /etc/squid.conf, dont chaque paramètre est documenté.

Toute la configuration de Squid se trouve dans le fichier squid.conf. La plupart des options par défaut du fichier ne sont pas à changer (vous pouvez alors laisser le # pour conserver les options en commentaire.)

http_port : le port que vous souhaitez utiliser. Le plus fréquent est 8080. Il faut donc changer cette valeur car par défaut Squid utilise 3128.

icp_port : conserver le port 3130. Ceci vous permet de communiquer avec des proxy-cache parents ou voisins.

cache_mem : correspond au cache mémoire, la valeur dépend de votre système. Par défaut squid utilise 8 Mo. Cette taille doit être la plus grande possible afin d’améliorer les performances (Considérez 1/3 de la mémoire que vous réservez à Squid). Il faut avec cache_mem régler cache_mem_low et cache_mem_high qui sont les valeurs limites de remplissage du cache mémoire. Par défaut les valeurs sont 75 % et 90 %. Lorsque la valeur de 90 % est atteinte le cache mémoire se vide jusqu’à 75 %. Les valeurs par défaut sont correctes dans la plupart des cas.

cache_swap : correspond à la taille de votre cache disque. Si la taille du disque le permet, et en fonction de la taille de votre établissement (nombre de clients qui utilisent le cache), mais aussi de la durée de rafraîchissement de votre cache et du débit de votre ligne, vous devez mettre la valeur qui vous semble correspondre à votre situation.

acl QUERY urlpath_regex cgi-bin \? \.cgi \.pl \.php3 \.asp : Type de page à ne pas garder dans le cache afin de pas avoir les données d’un formulaire par exemple.

maximum_object_size : taille maximale de l’objet qui sera sauvegardé sur le disque. On peut garder la valeur par défaut.

cache_dir : Vous indiquez ici le volume de votre cache. Si vous avez plusieurs disques, utilisez plusieurs fois cette ligne. Si squid ne fonctionne pas bien ou s’arrête parfois sans raison apparente, vérifiez que vous avez un cache assez important ou bien configuré.

cache_dir ufs /cache1 100 16 256 (cache de 100 Mb)

cache_dir ufs /cache2 200 16 256 (cache de 200 Mb)

Les valeurs 16 et 256, indiquent le nombre de sous-répertoires créés respectivement dans le premier niveau et suivants pour le stockage des données du cache.

cache_access_log ; cache_log ; cache_store_log : Indique l’endroit où se trouve les logs (fichiers de journalisation). Si vous ne souhaitez pas avoir de log (par exemple des objets cache_store_log) indiquer cache_store_log none.

debug_options ALL,1 : niveau de debug. Indiquer 9 pour avoir toutes les traces à la place de 1. Attention cela donne de gros fichiers.

dns_children : par défaut le nombre de processus simultanés dns est de 5. Il peut être nécessaire d’augmenter ce nombre afin que Squid ne se trouve pas bloqué. Attention de ne pas trop l’augmenter cela peut poser des problèmes de performance à votre machine (indiquer 10 ou 15).

request_size : taille maximale des requêtes. Conserver la valeur par défaut, concerne les requêtes de type GET, POST…

refresh_pattern : permet de configurer la durée de mise à jour du cache. Utiliser -i pour ne pas tenir compte des minuscules ou des majuscules. (voir le fichier squid.conf). Les valeurs Min et Max sont indiquées en minutes. Exemple :

# refresh_pattern ^ftp: 1440 20% 10080

visible_hostname : indiquer ici le nom de votre serveur proxy.

logfile_rotate : pour faire tourner vos logs et garder un nombre de copies. par défaut 10. attention si votre cache est très utilisé , il peut générer un grand volume de logs, pensez donc à réduire ce nombre.

error_directory : Pour avoir les messages d’erreurs en français (indiquer le répertoire où ils se trouvent). Exemple :

#error_directory /etc/squid/errors

#Créer un lien vers le répertoire où sont logés les messages en Français.

Cela n’est réalisé que la première fois afin de générer le cache.

squid -z

36.4. Les options de démarrage de Squid

On peut démarrer Squid en lui passant des commandes sur la ligne de commande. Différents paramètres peuvent être passés sur la ligne de commande. Les options passées de cette façon remplacent les paramètres du fichier de configuration de Squid squid.conf.

-h : Pour obtenir les options possibles

-a : Pour indiquer un port particulier

-f : pour utiliser un autre fichier de conf au lieu de squid.conf

-u : spécifie un port pour les requêtes ICP. (3110 par défaut)

-v : pour indiquer la version de Squid

-z : Pour initialiser le disque cache.

-k : Pour envoyer des instructions à Squid pendant son fonctionnement.

Il faut faire suivre -k d’une instruction

(rotate|reconfigure|shutdown|interrupt|kill|debug|check).

-D : pour démarrer squid lorsque vous n’êtes pas connecté en

permanence à internet (évite de vérifier si le serveur DNS répond).

Pour contrôler tout ce qui passe par votre serveur proxy, vous pouvez utiliser ce que l’on appelle les ACL (Access Control List). Les ACL sont des règles que le serveur applique. Cela permet par exemple d’autoriser ou d’interdire certaines transactions.

On peut autoriser ou interdire en fonction du domaine, du protocole, de l’adresse IP, du numéro de port, d’un mot, on peut aussi limiter sur des plages horaires.

La syntaxe d’une ACL est la suivante :

acl aclname acltype string[string2]

http_access allow|deny [!]aclname

acltype peut prendre comme valeur :

src (pour la source) : indication de l’adresse IP du client sous la

forme adresse/masque. On peut aussi donner une plage d’adresses

sous la forme adresse_IP_debut-adresse_IP_fin

dst (pour la destination) : idem que pour src, mais on vise

l’adresse IP de l’ordinateur cible.

srcdomain : Le domaine du client

dstdomain : Le domaine de destination.

url_regex : Une chaîne contenu dans l’URL

(on peut utiliser les jokers ou un fichier).

urlpath_regex : Une chaîne comparée avec le chemin de l’URL

(on peut utiliser les jokers).

proto : Pour le protocole.

Exemple 1 : Interdire l’accès à un domaine : supposons que nous souhaitions interdire l’accès à un domaine (par exemple le domaine pas_beau.fr). On a donc

acl veuxpas dstdomain pas_beau.fr

http_access deny veuxpas

http_access allow all # On accepte tout

La dernière ligne ne doit exister qu’une fois dans le fichier squid.conf.

Exemple 2 : interdire l’accès aux pages contenant le mot jeu.

acl jeu url_regex jeu

http_access deny jeu

http_access allow all

Attention url_regex est sensible aux majuscules/minuscules. Pour interdire JEU, il faut aussi ajouter JEU dans votre ACL. Il n’est pas besoin de réécrire toute l’ACL. On peut ajouter JEU derrière jeu en laissant un blanc comme séparation (cela correspond à l’opérateur logique OU).

On peut placer un nom de fichier à la place d’une série de mots ou d’adresses, pour cela donner le nom de fichier entre guillemets. Chaque ligne de ce fichier doit contenir une entrée.

Exemple 3 : utilisation d’un fichier

# URL interdites

acl url_interdites url_regex « /etc/squid/denied_url »

http_access deny url_interdites

Des produits associés à Squid (redirecteurs) permettent un contrôle plus simple. SquidGuard, par exemple, permet d’interdire des milliers de sites. Le site d’information est référencé plus loin dans la rubrique » liens « . Pensez, si vous utilisez SquidGuard, à configurer la ligne suivante dans le fichier squid.conf :

redirect_program /usr/local/squid/bin/SquidGuard

Exemple 4 : pour contrôler qui a le droit d’utiliser votre cache, créez une ACL du type :

acl si_OK src 192.168.0.0/255.255.0.0

http_access allow localhost

http_access allow site_OK

http_access deny all

36.6. Contrôler les accès par authentification

Parmi les demandes qui reviennent le plus souvent, la question de l’utilisation de Squid pour contrôler qui a le droit d’aller sur internet, est l’une des plus fréquentes.

On peut imaginer deux solutions :

La première consiste à contrôler les accès par salle et par horaires, en fonction d’un plan d’adressage de votre établissement. Le travail de l’académie de Grenoble avec ls projet SLIS permet de faire cela. On l’administre avec une interface Web. Ce n’est alors pas Squid qui est utilisé pour cela mais les fonctions de filtrage du routeur (netfilter par exemple). Construire des ACL directement dans Squid est faisable, mais cela n’est pas toujours simple à mettre en oeuvre.

La deuxième solution est de contrôler en fonction des individus. Squid permet de faire cela, à partir de plusieurs façons (APM, LDAP, NCSA auth, SMB…). Les différentes techniques sont décrites dans la FAQ de Squid sur le site officiel. Squid

Si vous utilisez un annuaire LDAP, vous devez avoir dans le fichier squid.conf les lignes suivantes :

acl identification proxy_auth REQUIRED

http_access allow identification

authentificate_program /usr/lib/squid/squid_ldap_auth \

-b $LDAP_USER -u uid SERVEUR_LDAP

LDAP_USER est l’ou (organizational unit) dans laquelle se trouve les clients

(par exemple ou=people, ou= ac-limoges, ou=education, ou=gouv, c=fr).

Si vous n’avez pas de serveur LDAP, une méthode simple à mettre en oeuvre, consiste à utiliser une méthode similaire au fichier .htaccess d’Apache.

Exemple de configuration avec NCSA_auth

authenticate_program /usr/lib/ncsa_auth /etc/squid/passwd

acl foo proxy_auth REQUIRED

acl all src 0/0

http_access allow foo

http_access deny all

36.7. Interface web de Squid et produits complémentaires

Squid dispose en standard de quelques outils, mais sinon vous pouvez utiliser webmin. Vous trouverez également, sur le site officiel de squid, une liste de produits supplémentaires pouvant être interfacés avec Squid.

Squid journalise les transactions dans un fichier access.log. Ce fichier donne les informations sur les requêtes qui ont transité par Squid. Le fichier cache.log informe sur l’état du serveur lors de son démarrage. Le fichier store.log informe sur les objets stockés dans le cache.

Les dates indiquées dans le fichier access.log indique le temps en secondes depuis le 1 janvier 1970 (format epoch), ce qui n’est pas très facile à lire. Un petit script en perl, permet de recoder les dates :

#! /usr/bin/perl -p

s/^\d+\.\d+/localtime $&/e;

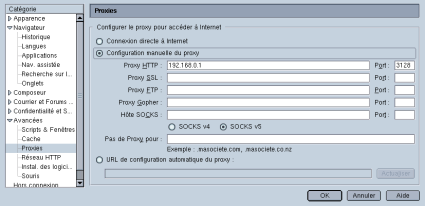

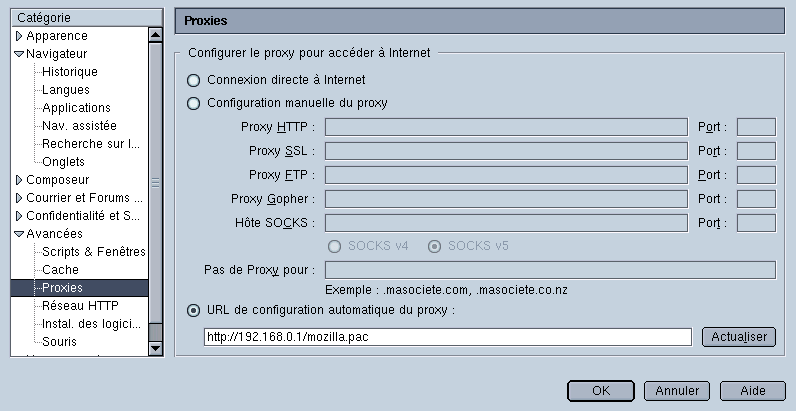

Pour configurer les clients, on peut utiliser la configuration manuelle ou la configuration automatique avec des fichiers .pac ou des fichiers .reg que l’on place dans le script de connexion des clients.

Configuration manuelle des clients

36.10. Forcer le passage par Squid (Proxy transparent)

Il existe plusieurs solutions :

Configurer votre navigateur avec le bon proxy ou en utilisant le fichier de configuration automatique et le rendre impossible à changer. Mais cela nécessite que vous contrôliez les clients ce qui n’est pas toujours le cas.

Intercepter les requêtes sur le port 80 du routeur pour les rediriger sur Squid.

Vous devez alors avoir dans votre fichier squid.conf :

# Configuration de traitement des requêtes du client

httpd_accel_host virtual

httpd_accel_port 80

httpd_accel_with_proxy on

httpd_accel_uses_host_header on

httpd_accel_single_host off

Puis ajouter la règle pour netfilter de redirection des requêtes sur le port 80

iptables -t nat -F PREROUTING

iptables -t nat -A PREROUTING -i eth0 -p tcp –dport 80 \

-j REDIRECT –to-port 8080

# Les clients peuvent envoyer leurs requêtes sur le port 80 du proxy

# Le service NAT du routeur les redirige sur le port 8080

36.11. Le redirecteur SquidGuard

Squid dispose d’une fonctionnalité qui permet de passer une URL (requête entrante) à une application externe. Cela présente l’avantage de pouvoir bénéficier des services d’applications spécialisées. C’est par exemple le cas pour le redirecteur SquidGuard, largement utilisé pour protéger les accès sur des sites déclarés comme » impropres « . Une base de données de ces sites est tenue à jour. C’est cette dernière qui est utilisée pour filtrer les accès.

36.12. Les applications non prises en charge par un service proxy

Certaines applications ne sont pas prises en charge par Squid (https, smtp, pop, ftp…). Les raisons peuvent être diverses. Soit le service n’est pas pris en charge (pop, smtp…), soit il n’est pas conseillé de stocker en cache certaines informations d’authentification par exemple (https).

Pour les applications ou services non pris en charge par un service proxy, vous devrez utiliser l’ipmasquerade, un service de translation d’adresse ou utiliser une autre technologie.

Chapter 37. Travaux pratiques : installation de SQUID

Vous devez maîtriser les techniques de routage avec netfilter.

Vous allez installer un service proxy minimal, configurer les clients puis tester le fonctionnement de l’accès à internet à partir des clients.

Vous configurerez des ACLs permettant un contrôle d’accès aux données externes, vous ferez ensuite évoluer cette configuration vers un service mandataire transparent.

Le service proxy sera installé sur le routeur.

Utilisez les éléments de ce document, ainsi que les exemples de fichiers de configuration donnés en annexe. Vous pourrez également vous référer au document sur netfilter.

37.1.1. Préparation de la maquette

Vous avez un routeur qui vous relie au réseau de l’établissement et un client qui représente un segment de réseau privé. L’ensemble doit fonctionner (accès à internet, résolution de nom, masquage d’adresse.

iptables -t nat -A POSTROUTING -s 192.168.0.0/24 -j MASQUERADE

# si 192.168.0.0 est le réseau privé

Vérifier que le routeur fonctionne. Faites un test à partir du client. Supprimez au besoin toutes les règles iptables et activez l’ipmasquerade.

Mettez une règle qui interdise toute requête à destination d’une application HTTP (port 80). Vérifier que les clients ne peuvent plus sortir.

# Ici on bloque tout, c’est brutal, mais on va faire avec.

iptables -P FORWARD DROP

37.1.2. Installation et configuration du service proxy

Faites une sauvegarde de votre fichier de configuration original (/etc/squid.conf). Modifiez le fichier de configuration de squid en vous appuyant sur celui donné ci-dessous.

http_port 3128

#We recommend you to use the following two lines.

acl QUERY urlpath_regex cgi-bin \?

no_cache deny QUERY

cache_mem 8 MBM

maximum_object_size_in_memory 8 KB

cache_dir ufs /var/spool/squid 100 16 256

cache_access_log /var/log/squid/access.log

cache_log /var/log/squid/cache.log

cache_store_log /var/log/squid/store.log

# Put your FQDN here

visible_hostname freeduc-sup.foo.org

pid_filename /var/run/squid.pid

#Recommended minimum configuration:

acl all src 0.0.0.0/0.0.0.0

acl manager proto cache_object

acl localhost src 127.0.0.1/255.255.255.255

#Recommended minimum configuration:

http_access allow manager localhost

http_access allow all

Initialisez l’espace disque pour le cache.

# Vérifiez que le FQDN de votre serveur est renseigné

# et que la résolution de nom locale fonctionne (fichier hosts ou DNS).

# initialisation de la zone de cache

squid -z

# Lancement de squid

/etc/init.d/squid start | restart

Démarrer et vérifier le bon fonctionnement de Squid. Consultez également les journaux.

$>ps aux | grep squid

root 2984 0.0 0.4 4048 1124 ? S 15:22 0:00 \

/usr/sbin/squid -D -sYC

proxy 2987 2.1 1.6 6148 4068 ? S 15:22 0:00 (squid) -D -sYC

Vérifier que le port d’écoute est correct.

mlx@uranus:~$ netstat -atup | grep LISTEN

(Tous les processus ne peuvent être identifiés, les infos sur

les processus non possédés ne seront pas affichées, vous devez

être root pour les voir toutes.)

tcp 0 0 *:3128 *:* LISTEN –

Identifiez l’endroit de stockage du cache sur le disque.

37.1.3. Configuration du client

Configurer le client pour qu’il utilise le service proxy sur les requêtes HTTP, vérifier le bon fonctionnement.

Figure 37-1. Configuration du client

Identifiez les traces dans les journaux.

root@uranus:/home/mlx# more /var/log/squid/access.log

1053864320.437 1741 192.168.0.2 TCP_MISS/200 5552 \

GET http://www.cru.fr/documents/ – DIRECT/195.220.94.166 text/html

1053864320.837 1096 192.168.0.2 TCP_MISS/304 331 \

GET http://www.cru.fr/styles/default.css – DIRECT/195.220.94.166 –

1053864321.257 420 192.168.0.2 TCP_MISS/304 331 \

GET http://www.cru.fr/logos/logo-cru-150×53.gif – DIRECT/195.220.94

1053864321.587 696 192.168.0.2 TCP_MISS/304 331 \

GET http://www.cru.fr/icons-cru/mailto.gif – DIRECT/195.220.94.166

1053864550.537 1461 192.168.0.2 TCP_MISS/200 5552 \

GET http://www.cru.fr/documents/ – DIRECT/195.220.94.166 text/htm

Interdisez tous les accès avec la règle :

http_access deny all

Vérifiez le fonctionnement.

37.1.4. Mise en place d’une ACL simple

Interdisez l’accès à un serveur (google.fr) par exemple. Vérifiez le fonctionnement.

acl google dstdomain .google.fr

http_access deny google

37.1.5. Utilisation de fichiers pour stocker les règles des ACL

Construisez deux fichiers, l’un qui permettra de stocker des adresses IP, l’autre des mots clés. Construisez une ACL qui interdit l’accès en sortie aux machines qui ont les adresses IP déterminées dans le premier fichier, et une ACL qui empêche l’accès aux URL qui contiennent les mots clés stockés dans le second fichier.

# Exemple de ce que le fichier « adresse_ip » contient :

# Mettez dans la liste des adresses celle de votre client pour tester

192.168.0.2

192.168.0.10

# Exemple de ce que le fichier « mot_cle » contient :

jeu

game

# Exemple d’ACL

acl porn url_regex « /etc/squid/mot_cle »

acl salleTP_PAS_OK src « /etc/squid/adresse_ip »

http_access deny porn

http_access deny salleTP_PAS_OK

Tester le fonctionnement de ces deux ACL. (Utiliser comme url de destination par exemple http://games.yahoo.com/)

37.1.6. Configuration des messages d’erreurs

Configurez Squid pour qu’il affiche des pages (messages d’erreur) en Français. Vérifiez le fonctionnement.

error_directory /usr/share/squid/errors/French

Identifiez la page qui est retournée lors d’un refus d’accès. Modifiez la page et le message retourné, puis vérifiez le fonctionnement.